这么个流程:

👇假定神经网络是某一种结构

👇将一堆训练数据输入到这个网络中

⚠估计这个网络的待求参数

⚠算法模型的复杂度要和训练样本的复杂度匹配=>对于训练样本很多的情况->增加神经网络的层数和神经元的个数

统一式子表达:y=(ω1ω11+ω2ω21)x1+(ω1ω12+ω2ω22)x2+(ω1b1+ω2b2+b3)【上一章的东西】

使小y和标签Y尽可能接近:

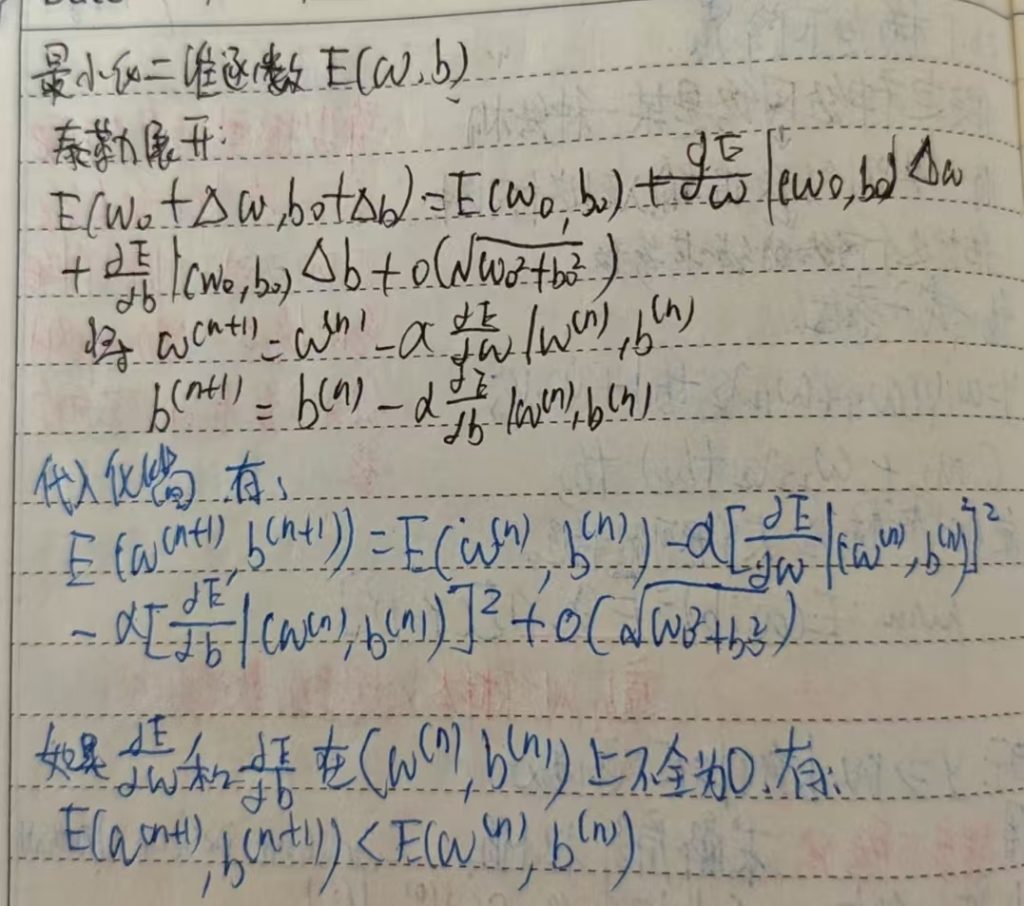

Min:E(ω,b)=E(X,Y)[(Y-y)2]

遍历训练样本及标签的数学期望

由于y=>ω,b的非凸函数

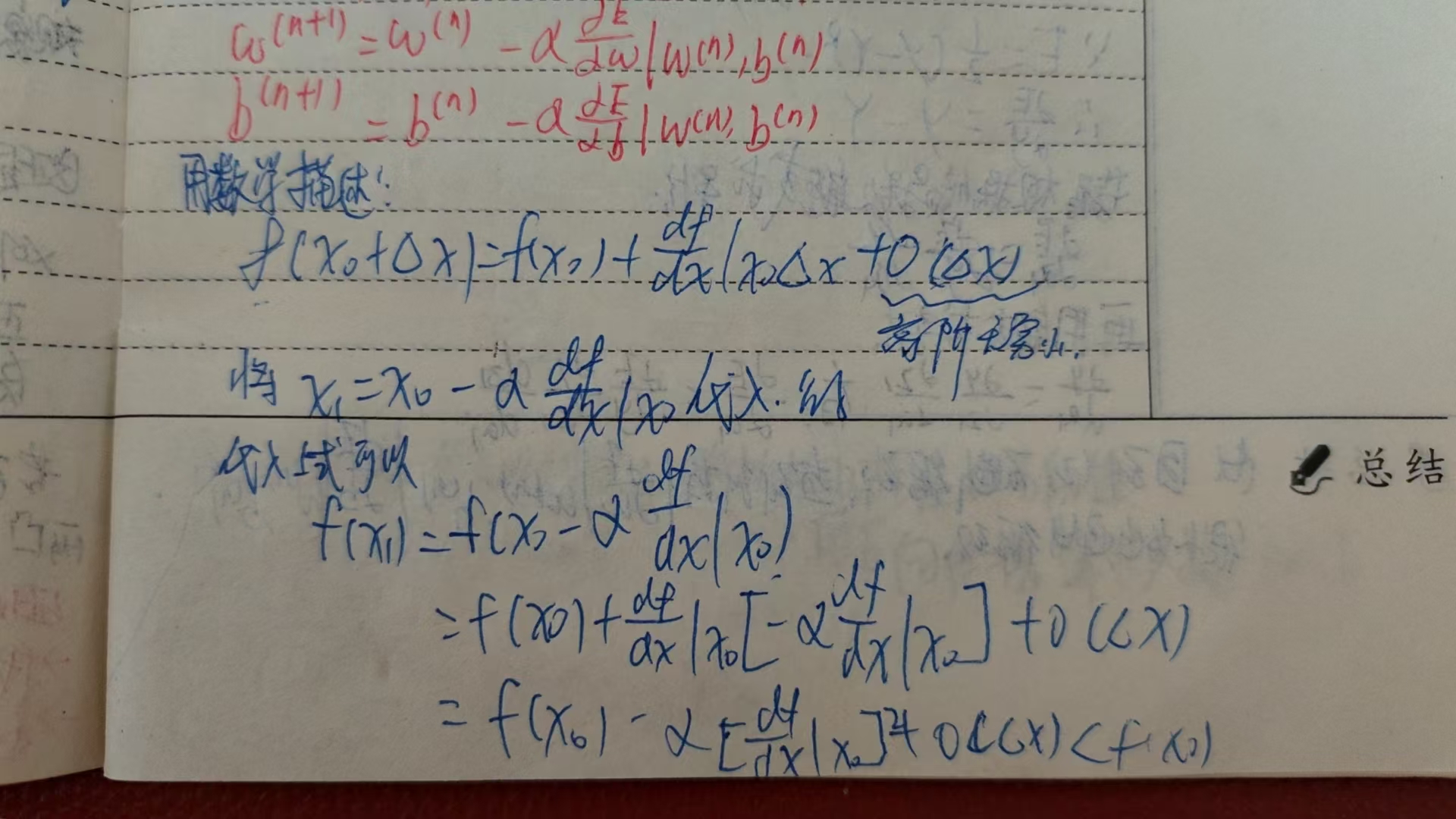

用梯度下降法(Gradient Descent Method)求解局部极小值

(1)随机选取ω和b的初始值(ω(0),b(0))

(2)应用迭代算法发求目标函数的局部极值

在第n步迭代中,ω和b的更新公式如下:

微信扫描下方的二维码阅读本文