SVM内核总结(视频P66)

四种经典核函数:

- Linear(线性内核)

- Ploy(多项式核)

- Rbf(高斯径向基函数核)

- Tanh核

🟩 1. Linear 核(线性核)

📐 数学形式:

K(x,x′)=x⊤x′

就是两个样本向量的点积

🔍 解释:

- 不进行任何“升维变换”,直接在线性空间找分隔超平面

- 与原始空间完全一致 ⇒ 不适用于非线性问题

✅ 适合:

- 特征数远大于样本数(如文本分类、基因数据)

- 数据本身就是线性可分的或近似线性

❌ 不适合:

- 数据存在复杂边界或非线性结构

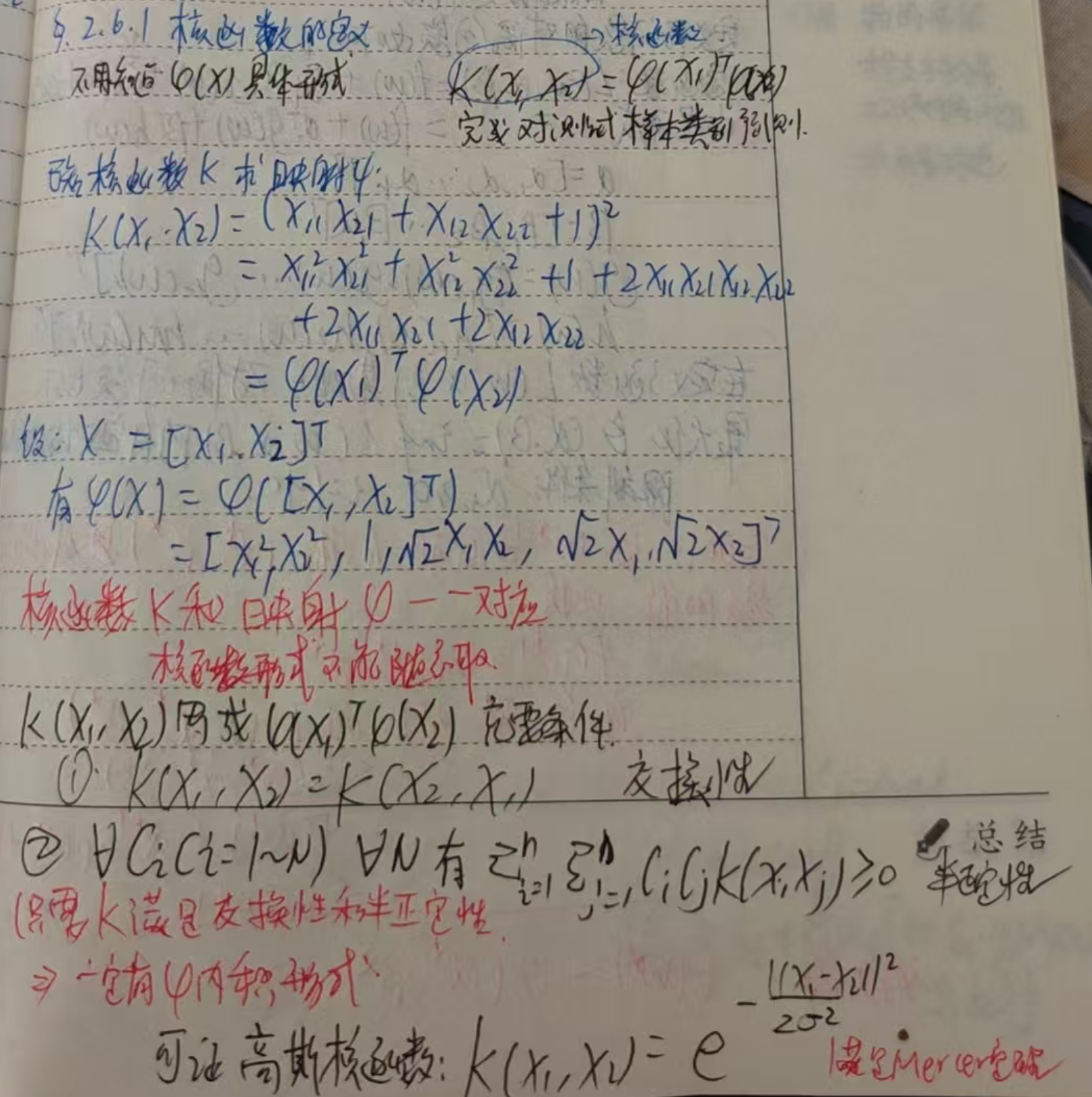

🟦 2. Polynomial 核(多项式核)

📐 数学形式:

K(x,x′)=(x⊤x′+c)d

- d:多项式的次数(degree)#d越大,维度越高越复杂。

- c:常数项偏移(常为 0 或 1)

🔍 解释:

- 实现“非线性升维”,相当于把原始空间映射到了高维多项式空间

- 可以捕捉交叉特征、高阶相关性(比如 x1x2,x12等)

✅ 适合:

- 特征之间有“乘法”关系或复杂交互项

- 结构比线性稍复杂,但不至于需要无限维

❌ 不适合:

- 高维 + 高次数时容易过拟合

- 相比 RBF 通用性稍差

🟨 3. RBF 核(高斯径向基函数核)

📐 数学形式:

K(x,x′)=exp(−γ||x−x′||2)

其中:

- γ=1/2σ2,控制核函数“宽度”

🔍 解释:

- 把每个样本映射到一个“高斯山”,类似于“无限维”变换

- 非常强大,能处理几乎任意复杂的非线性结构

✅ 适合:

- 数据分布复杂或没有明显结构

- 几乎是默认最通用核

❌ 不适合:

- 对参数 γ 和 C 较敏感 ⇒ 需要调参

- 在特征数远大于样本数场景下可能过拟合

🟥 4. Tanh 核(双曲正切核 / Sigmoid 核)

📐 数学形式:

K(x,x′)=tanh(κ⋅x⊤x′+c)

- κ、c:可调参数

🔍 解释:

- 受到神经网络中激活函数 tanh() 启发

- 早期用来模拟单隐层神经网络的效果

✅ 适合:

- 某些二分类问题

- 与神经网络对比实验时

❌ 不适合:

- 效果常常不如 RBF 核

- 不是一个严格的“Mercer 核”(并非对所有参数都满足正定性)

- 调参难,容易导致非收敛

🔁 对比总结表格:

| 核函数 | 映射类型 | 是否非线性 | 是否需要调参 | 是否默认推荐 | 特点 |

|---|---|---|---|---|---|

| Linear | 无升维 | 否 | 否 | ✅ 对线性问题很好 | 简单快速,不会过拟合 |

| Polynomial | 映射到多项式 | 是 | ✅ d, c | ❌ | 能捕捉高阶特征组合 |

| RBF | 映射到无限维 | 是 | ✅ γ, C | ✅ 最常用 | 万能核函数,能处理复杂边界 |

| Tanh | 类神经网络激活 | 是 | ✅ κ, c | ❌ | 模拟神经元激活效果,常不稳定 |

📌 选核函数时的建议:

| 你的问题 | 推荐核 |

|---|---|

| 数据近似线性 | Linear 核 |

| 数据特征有交互/多项式形式 | Polynomial 核 |

| 数据结构复杂/不清楚结构 | RBF 核(首选) |

| 做研究、类比神经网络 | Tanh 核(试试看) |

微信扫描下方的二维码阅读本文